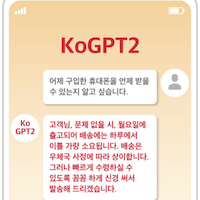

KoGPT2

Korean GPT(Generative Pre-trained Transformer) 2

GPT-2는 머신러닝 알고리즘을 활용해 입력된 샘플 텍스트를 구문론적, 문법적, 정보 등의 일관성을 갖춘 텍스트로 생성하는 자연어 처리 모델이다. 한국어로 학습된 오픈소스 기반 GPT-2 모델인 KoGPT-2는 질문에 대한 응답 생성, 문장 완성, 챗봇 등 한국어 해석이 필요한 여러 애플리케이션의 머신러닝 성능을 향상할 수 있다.

챗봇 구축, 텍스트 감성 예측, 텍스트 분석 기반 응답 생성에 사용될 수 있으며, 관심 있는 개발자는 모델과 관련 소스를 다운로드해 프로젝트에 적용하거나 수정하면 된다.

SKT는 사회적 미션의 일환이자 머신러닝 커뮤니티 성장에 기여하기 위해 KoGPT-2 개발과 공개를 결정했다.

- GitHub : https://github.com/SKT-AI/KoGPT2

Feedback

Was this page helpful?

Glad to hear it! Please tell us how we can improve.

Sorry to hear that. Please tell us how we can improve.

최종 수정 2021년 2일 14월: renewal (50136428)